Jak skutecznie prowadzić kampanię w AdWords?

Funkcja Eksperymentu AdWords pozwala na testowanie alternatywnych ustawień kampanii w równolegle prowadzonych testach A/B (znajdziemy ją na karcie ustawień kampanii). Możemy porównywać, jak zachowywać się będzie kampania czy grupa reklam przy zastosowaniu innych stawek oferowanych za słowa kluczowe oraz jaką skuteczność mają różne kreacje reklamowe.

Kiedy prowadzimy eksperymenty, ważne jest, aby nie wyciągać przedwcześnie wniosków. O tym, że należy zachować umiar w analizach, pisaliśmy już wcześniej:

http://mambiznes.pl/artykuly/czytaj/id/5779/google_analitics_jak_czytac_dane_i_unikac_bledow.

Poniższy przykład pokaże, że nie należy wyciągać pochopnych wniosków z wyników eksperymentu.

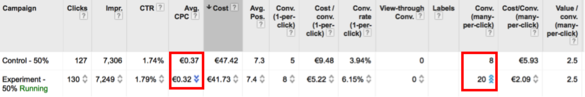

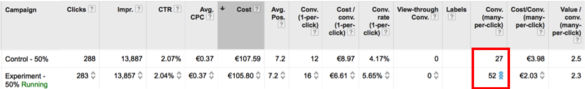

W pierwszym dniu po rozpoczęciu testowania dwóch alternatywnych ustawień kampanii, zobaczyliśmy dosyć istotne różnice CPC i CTR. Co prawda danych było jeszcze niewiele, ale system pokazał już istotność statystyczną z poziomem ufności 95% dla różnic w CPC (liczba niebieskich strzałek przy wyniku wskazuje na poziom ufności). Widzimy też, że wersja kontrolna nie konwertuje:

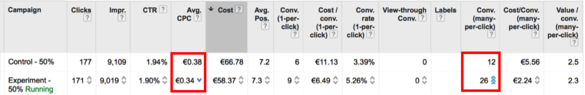

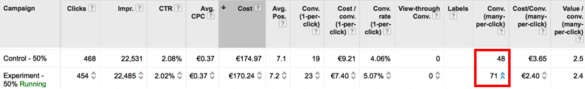

Postanawiamy jednak poczekać, tym bardziej że system może raportować dane z pewnym opóźnieniem. Następnego dnia sytuacja wygląda jednak dosyć podobnie. System już nie pokazuje, aby wynik miał istotność statystyczną, choć próba jest już 2 razy większa i wciąż widzimy sporą rozbieżność w CPC i konwersjach (jedna/kliknięcie oraz wiele/kliknięcie):

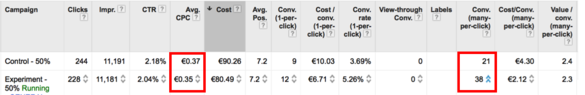

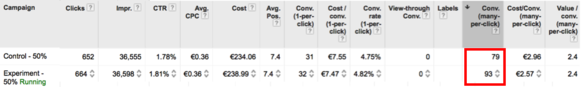

Kolejna obserwacja: System stwierdza, że obserwowana różnica w CPC ma 99% poziom ufności, czyli że prawdopodobnie możemy kupować ruch taniej w ustawieniach eksperymentalnych, przy wyższym CTR. System pokazuje także 99,9% istotność statystyczną różnic w konwersjach wiele/kliknięcie, których w eksperymencie jest ponad dwa razy więcej:

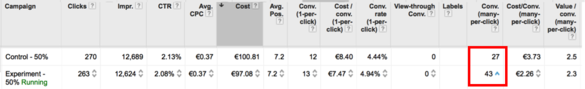

Mimo to postanawiamy jeszcze poczekać. Kolejny dzień pokazuje w zasadzie to samo, choć system uznał, że różnica w CPC ma istotność statystyczną z jedynie 95% poziomem ufności. Jednak – jak wskazuje system – na 99,9% różnice w konwersjach wiele/kliknięcie nie są dziełem przypadku i w eksperymencie jest ich wciąż ponad dwa razy więcej:

W kolejnym dniu różnica w CPC gwałtownie zmalała i system wycofał się z twierdzenia, że ma ona istotność statystyczną. Poziom ufności dla różnic w konwersji zmalał również do „jedynie” 99%:

Dzień później wartości CPC w próbie kontrolnej i eksperymencie się zrównały, a poziom ufności dla różnic w konwersjach zmniejszył się do 95%:

Kolejny dzień przyniósł znaczy wzrost konwersji w wersji eksperymentalnej. System przywrócił tej, prawie dwukrotnej różnicy, istotność statystyczną z poziomem ufności 99,9%:

Po kilku dniach przewaga się zmniejszyła, ale wciąż widoczna jest istotna różnica w liczbie konwersji (system wskazuje na istotność statystyczną z 99% poziomem ufności):

Kampania trwa. Różnice między próbą kontrolną i eksperymentem zmniejszyły się. Liczba konwersji (wiele/kliknięcie) w eksperymencie jest o ok. 18% większa, ale system wskazuje, że nie ma ona istotności statystycznej:

Następnego dnia różnica w konwersjach wiele/kliknięcie znów się powiększa i ponownie pojawiła się istotność statystyczna na poziomie 95%:

Na tym skończyliśmy eksperyment. Rzecz jednak w tym, że wersja kontrolna i eksperymentalna nie różniły się niczym. Kampania została po prostu podzielona na dwie równe części i różnice w ich skuteczności były w 100% dziełem przypadku.

System AdWords jest systemem niezwykle dynamicznym, w którym na wynik wpływa bardzo duża liczba zmiennych losowych (wysoka liczba stopni swobody). Dotyczy to w szczególności konwersji (znacznie mniej w przypadku danych dotyczących wyświetleń, kliknięć, pozycji i CTR). Wydaje się też, że narzędzie systemowe przeszacowuje istotność statystyczną uzyskiwanych wyników. Dlatego wyniki eksperymentu należy zawsze analizować w oparciu o odpowiednią próbkę danych, nawet jeśli system pokazuje, że obserwowane różnice mają istotność statystyczną.

Jeżeli nawet system AdWords nie pokazuje istotności statystycznej, wyciąganie wniosków na podstawie wyników takiego eksperymentu byłoby podążaniem za chaosem. Często warto zastanowić się nad przyczynami, dla których określona wersja kampanii miałaby mieć lepszą skuteczność i jeśli nie znajdujemy takich powodów – poczekać jeszcze jakiś czas z podjęciem decyzji.

Witold Włodarczyk

Dziekuje za odpowiedz. Tak sie tylko glosno zastanawialem, czy jest to zwykly test t, w oparciu o centralne twierdzenie graniczne, czy cos innego. Pozdrawiam